ホクソエムサポーターの白井です。 今回は前回 【翻訳】機械学習の技術的負債の重箱の隅をつつく (前編) の続きを紹介します。

※この記事は、Matthew McAteer氏によるブログ記事Nitpicking Machine Learning Technical Debtの和訳です。原著者の許可取得済みです。

後編では、コードのアンチパターンなど、エンジニアには身近な話題で、前編と比較して実践しやすいコンテンツも多いと思います。

- Nitpicking Machine Learning Technical Debt (機械学習の技術的負債の重箱の隅をつつく)

- Part5 MLコードにある共通のダメなパターン

- Part6 構成の負債 (退屈だけど修正は簡単)

- Part7 解決への夢を打ち砕く実世界

- Part8 奇妙なメタセクション

- Part9 技術的負債のリトマス試験

- The 25 Best Practices in one place

- おわりに・参考資料

Nitpicking Machine Learning Technical Debt (機械学習の技術的負債の重箱の隅をつつく)

再注目されているNeurIPS2015の論文を再読する (そして、2020年のための、より関連した25のベストプラクティス)

Part5 MLコードにある共通のダメなパターン

技術的負債論文の 「アンチパターン」の章は前の章よりも実践可能でした。 このパートは前パート(フィードバックループ)よりもより高レベルな抽象的なパターンを扱います。

(これは実際は技術的負債論文の情報を表にしたもので、さらにその修正方法に関するアドバイスへのハイパーリンクをつけています。

この表は、著者らがML特有のコードの臭いとアンチパターンについて議論したもので、もしかしたらちょっとやりすぎかもしれませんが、 すべてはじめに着手すべき標準的なソフトウェアエンジニアリングのアンチパターンに相当しています。)

| 設計の失敗 | 種類 |

|---|---|

| 機能の横恋慕 (Feature Envy) | コードの臭い |

| データクラス (Data Class) | コードの臭い |

| 長すぎるメソッド (Long Method) | コードの臭い |

| 長すぎるパラメーターリスト (Long Parameter List) | コードの臭い |

| 巨大なクラス (Large Class) | コードの臭い |

| 神オブジェクト (God Class) | アンチパターン |

| マルチツールナイフ(Swiss Army Knife) | アンチパターン |

| 機能分解 (Functional Decomposition) | アンチパターン |

| スパゲッティコード (Spaghetti Code) | アンチパターン |

(訳注: 日本語訳はwikipediaのアンチパターン、コードの臭いとソフトウェア開発 アンチパターンのまとめ を参考にした)

これらのパターンはその90%以上が、MLコードのモデル更新ではなく“モデルを維持している”部分に関連するものです。 これは、Kaggleコンペのほとんどの参加者は存在すると考えたことのないような配管 (plumbing) です。 細胞のセグメンテーションを解くのはずっと簡単です、モデルの入力をTacan Evo cameraとつなぐコードに大半の時間を浪費しない限りは。 (訳注: 上記Kaggleコンペのリンクは細胞のセグメンテーションコンペ)

Best practice #9 定期的なコードレビューを使おう (そして・またはコードチェックツールを使おう)

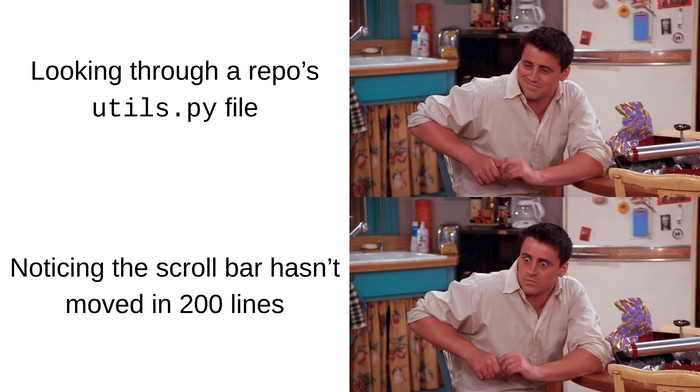

最初のMLのアンチパターンは 「グルーコード (glue code)」です。 グルーコードは汎用的な目的のパッケージから持ってきたデータやツールを、自分の持っているとても限定されたモデルにフィットしたい時に書いたコード全てを指します。 RDKitのようなパッケージでなにかしようとしたことのある人なら誰もが、私の言っている意味がわかるでしょう。

基本的に、 utils.py に押しやったものは大抵、これに該当します (誰もがやったことがあるはずです)。

これらは (できれば) もっと具体的なAPIエンドポイントに依存性をリパッケージして修正すべきです。

Best practice #10 汎用的な目的の依存関係は特定のAPIにリパッケージしよう

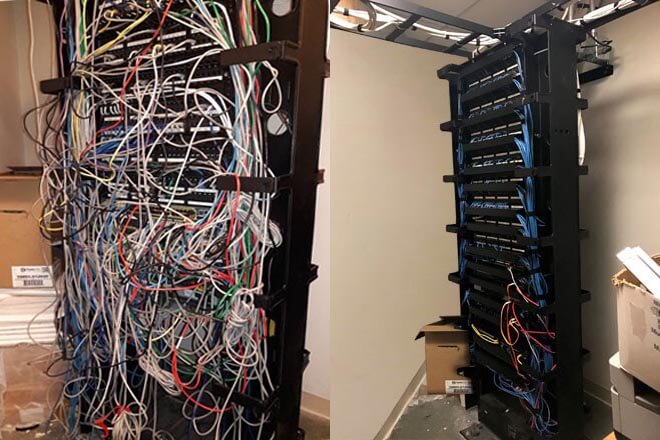

「パイプラインジャングル (pipeline jungles)」は少し厄介で、グルーコードが大量に蓄積された場所を指します。 すべてのちょっとした新しいデータに対する変換が、醜い混合物 (amalgam) として積み重なった場所です。 グルーコードとは異なり、著者らは、スクラッチからのコードベースを手放して、再設計するように強く薦めています。

今や他の選択肢があると言いたいところですが、グルーコードがパイプラインジャングルに変貌した時には、Uber's Michelangeloのようなツールですらむしろ問題の一部になりえます。

もちろん、著者らのアドバイスのメリットは、変換したコードを興奮するようなかっこいい名前の新しいプロジェクトにみせられるということです。 トルーキンの参照が義務付けられている「Balrog」のように。 (プロジェクトの名前の不幸な暗喩を無視しているのはPalantirのドメインだけではありません。 あなたもまた自由です。)

(訳注: Barlog(バルログ) も Palantir(パランティーア)もトルーキンの指輪物語 に登場する。 Palantirは物語において「見る石」であり、危険な道具である。)

Best practice #11 トップダウンの再設計・再実装によってパイプラインジャングルを取り除こう

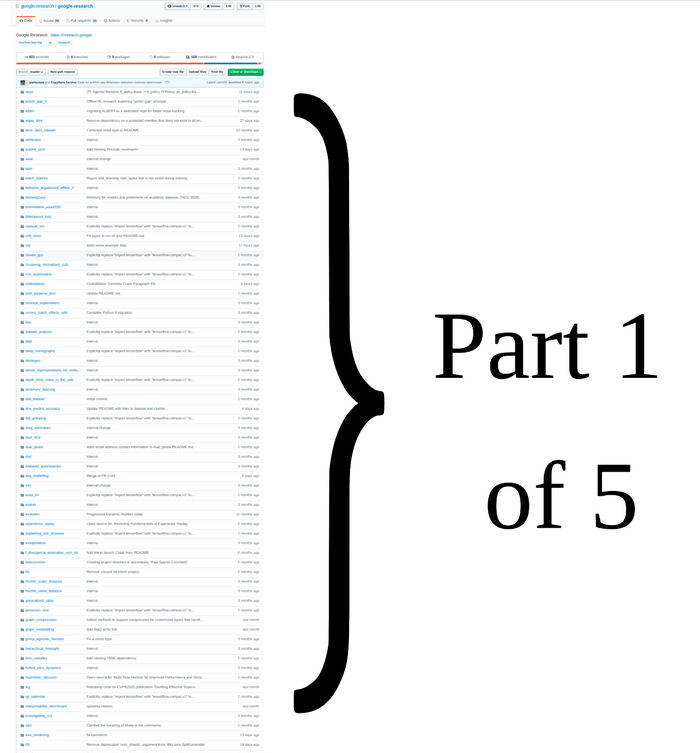

考えたくない話題、試験的コード (experimental code)について見ていきましょう。 あなたは後々のために試験的コードを保存しようと当然思うはずです。 使っていない関数や参照していないファイルにおいておけば、問題ないと思ったでしょう。 あいにく、このようなものは後方互換性の管理が頭痛のタネになる理由のひとつになります。

Tensorflowを深く掘り下げたことのある人であれば覚えがあるでしょう、一部だけ吸収されたフレームワークや、試験的コード、のちの日に気が付くエンジニアのために残された 未完了の「TODO」 コードに。 Tensorflowコードの謎の失敗をデバッグしようとした時、あなたは偶然これらを見つけたのではないでしょうか。 これは間違いなく、Tensorflow 1.Xと2.Xの間にある互換性の遅れを浮き彫りにしています。

自分自身のためにも、5年もコードベースの剪定から逃げるのはやめましょう。 実験をつづけても、他のコードから実験的コードを隔離する基準を定めましょう。

Google Researchの散らかった (少なくとも上位5位に入る) githubレポジトリ、しかも公開されているものです。

そして、READMEは同じぐらい詳細とは程遠く、実際は真逆です。

Google Researchの散らかった (少なくとも上位5位に入る) githubレポジトリ、しかも公開されているものです。

そして、READMEは同じぐらい詳細とは程遠く、実際は真逆です。

Best practice #12 定期的な点検を定めて、コードを取り除くための基準をつくろう、もしくはビジネスに重大な影響を及ぼすコードとは程遠いディレクトリやディスクにMLコードをおこう

古いコードといえば、ソフトウェアエンジニアリングが以前からなにをやってきたか知っていますか? それは本当に素晴らしい抽象化です! 関係データベースの概念からウェブページの表示まで、ありとあらゆることです。 応用カテゴリ理論には、コードを整理するためのベストなやり方を発見することに執念を燃やしている分野があります。

応用カテゴリ理論が、何にいまだ悩みつづけているか知っていますか? そう、機械学習のコード整理です。 ソフトウェアエンジニアリングは壁に抽象的なスパゲティーを投げて、なにが刺さるかを見る経験がありました。

機械学習? Map-Reduce (これは関係データベースのように印象的な概念ではない) や Async Parameter servers (どうやってすべきなのか誰も同意できない) や sync allreduce (多くの場合大失敗している) は別として、私たちが見せられるものはありません。

先ほど言及した、Sync AllReduce serverのアーキテクチャの大まかな概要 (かなり簡略化したバージョン)

先ほど言及した、Sync AllReduce serverのアーキテクチャの大まかな概要 (かなり簡略化したバージョン)

先ほど言及した、Async parameter serverのアーキテクチャの大まかな概要 (少なくともそのバージョンのひとつ)

先ほど言及した、Async parameter serverのアーキテクチャの大まかな概要 (少なくともそのバージョンのひとつ)

実際、ランダムネットワークの研究をしているグループとPytorchがニューラルネットワークのノードがいかに流動的であるかを宣伝している間に、 機械学習は抽象的なスパゲティーを窓から綺麗に投げ捨ててしまったのです! 著者らは、この問題が時間と共にとても悪くなっていることに気づいていたとは思いません。 私のおすすめ? 大まかな抽象化について、有名な文献を読みましょう。あと、プロダクションのコードにはPytorchを使わないほうがいいと思います。

Best practice #13 時間と共に強固になる抽象化を最新の状態にしておこう

私は今まで、お気に入りのフレームワークがあってほとんどの問題に対してそれをつかうのを好むシニアな機械学習エンジニアとたくさん会ってきました。 私はまた、彼らのお気に入りのフレームワークを新しい問題に適用するとき、そのフレームワークが破綻したり機能的に区別できない他のフレームワークに変更されたりするのを目の当たりにした同じエンジニアを見てきました。

これは特に、分散させて計算するタイプの機械学習処理を行うチームに多く見られます。 私にははっきりさせておきたいことがあります。

MapReduceは別として、なにかひとつのフレームワークに執着しすぎるのは避けるべきです。

あなたの “シニア(先輩)” 機械学習エンジニアが「Micheloangeloが最高で、全てを解決できる」と信じているならば、彼らはそれほどシニアではないかもしれません。

MLエンジニアリングは成熟してきた一方で、まだ相対的には早熟なのです。

本当の “シニア” なシニアMLエンジニアは、フレームワークにとらわれないワークフローを重要視するでしょう、なぜなら、フレームワークの多くは寿命が長くないと知っているからです。 ⚰️

さて、前のセクションで機械学習における技術的負債の区別できるシナリオや質について言及しましたが、技術負債論文では機械学習開発のための大まかなアンチパターンの例も提供しています。

これを読んでいる人の多くは、コードの臭い (code-smells) というフレーズを聞いたことがあるでしょう。 good-smellやPep8-auto-checking (さらにはみんながPythonコードに使っている、新しい自動フォーマッタ Black) のようなツールを使っているかもしれません。 正直に言うと、 「コードの臭い」という用語が好きではありません。

「臭い」は常に微妙なものを暗に意味しているようにみえますが、次のセクションに書かれたパターンは逆にとても露骨なものです。 それにもかかわらず、著者らは負債を大まかに示すコードの臭いの種類を少しだけ並べています (普通のコードの臭いの種類を超えて)。 なぜか、“コードの臭い”のセクションの途中からコードの臭いを記載し始めています。

「プレーンなデータ」の臭い (The "Plain data" smell)

numpy float形式のデータを大量に扱うコードをもっているかもしれません。 RNAの読み込み回数がベールヌイ分布からのサンプルを表現しているのかどうか、floatが数値の対数かどうかといった、データの性質を保持する情報がほとんどないことがあるかもしれません。

技術的負債論文では言及されていませんが、これはPythonのtypingが助けられる領域のひとつです。

不必要なfloatや、正確すぎるfloatの使用を避けることが大いに役に立ちます。

繰り返しますが、組み込みの Decimal や Typing パッケージを使うことはとても助けになります (コードを誘導するだけでなく、CPUのスピード向上にもなります)。

Best practice #14

TypingやDeimalのようなパッケージを使って、すべてのオブジェクトに対して 'float32' を使うのはやめよう

過半数のハッカソンコード、そして残念なことにベンチャーキャピタルに資金提供されている「AI」スタートアップのコードの中身はこんな感じです。

過半数のハッカソンコード、そして残念なことにベンチャーキャピタルに資金提供されている「AI」スタートアップのコードの中身はこんな感じです。

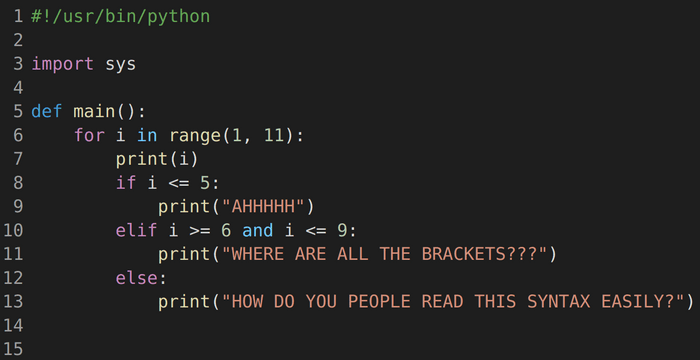

「試作品」の臭い(The "Prototyping" smell)

ハッカソンに参加した人なら知っているでしょうが、24時間以内に寄せ集めでつくられたコードはこんな形をしています。 これは、先ほど言及した実際には誰にも使われない試験的コードともつながっています。 生物学データのための PHATE次元削減ツールを試したくて興奮するかもしれませんが、コードをきれいにするか、投げ捨てるかしてください。

Best practice #15 進行中のものを同じディレクトリに置かない。片付けるか、きれいにしよう。

「多言語」の臭い (The "Muitl-Language" smell)

プログラミング言語の種類について言うと、多言語のコードベースは技術的負債が複数積み重なるように、その積み重なりがより早くなるよう振る舞います。 もちろん、すべての言語にはそれぞれ利点があります。 Pythonはアイデアを素早く構築するためには良いです。 Javascriptはインタフェースに向いています。 C++はグラフィックに最適で、計算もはやいです。 PHPは、うーん、特にこれといったものはないです。 GolangはKubernetesを使う (もしくはGoogleで働く) には便利です。

しかし、これらの言語でお互いに会話するとして、エンドポイントが壊れたり、メモリリークによって、うまくいかない点がたくさんあるでしょう。 少なくとも機械学習では、言語の間で似たセマンティクスを持つSparkやTensorflowのようなツールキットは少ないです。 もし複数の言語をどうしても使わなくてはいけなくても、少なくとも2015年以降はそれが可能になってはいます。

C++のプログラマーがPythonに転向したら。この人が書いたレポジトリ全体のコードを思い描いてみてください

C++のプログラマーがPythonに転向したら。この人が書いたレポジトリ全体のコードを思い描いてみてください

Best practice #16 エンドポイントが説明されていることを確認し、言語間で似たような抽象度を持つフレームワークを使用しよう

(これをコードの臭いと呼ぶのは奇妙な選択です、普通のコードの臭いを基準としても、これはとても露骨なパターンなので。)

Part6 構成の負債 (退屈だけど修正は簡単)

技術的負債論文の「構成の負債」の章はおそらく楽しいものではないですが、そこに記述されている問題は簡単に修正できます。

基本的に、機械学習のパイプラインについて、すべての調整可能で構成可能な情報を一箇所にまとめて、確かめる習慣であり、これはいうなればあなたの2番目のLSTMレイヤーのユニット数がどう設定されているか調べるために複数の辞書を探す必要のない状況のことです。 設定ファイルをつくる習慣を持っていても、すべてのパッケージと技術があなたを悩ませないわけではありません。

一般的な方針は別として、技術的負債論文のこの部分は詳細を十分に深堀りしていません。 技術的負債論文の著者らはCaffeのようなパッケージを使うのに慣れていたのではないかと疑っています (Caffeのプロトコルバッファーで設定ファイルを設定することは客観的に見てバグだらけで恐ろしいものでした)。

個人的には、もし設定ファイルを設定したいのであれば、tf.Keras や Chainer のようなフレームワークを使うことを提案します。

クラウドサービスはバージョンの構成管理機能をもっていますが、それ以外では、config.jsonか パラメーターフラグを使う準備をする必要があります。

Best practice #17 ファイルパスやハイパーパラメーター、レイヤーの種類、レイヤーの順番や他の設定が一つの場所から設定できるか確かめよう

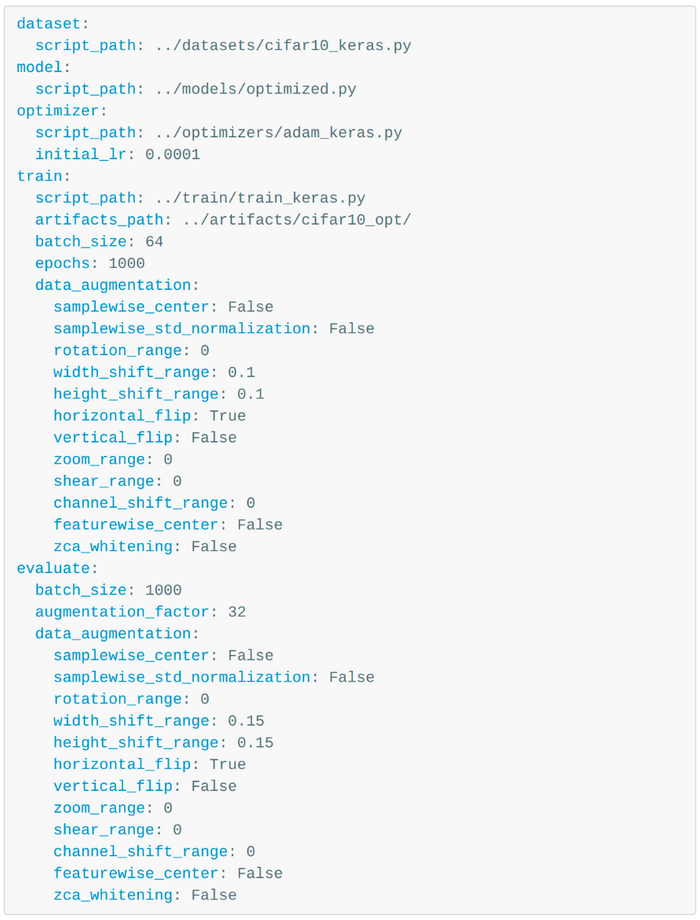

設定ファイルの素晴らしい例。

技術的負債論文はもっと例をあげたり、当時存在した設定ファイルのガイドについて指摘して欲しかったと切に思います。

設定ファイルの素晴らしい例。

技術的負債論文はもっと例をあげたり、当時存在した設定ファイルのガイドについて指摘して欲しかったと切に思います。

もしコマンドラインをつかってこれらの設定を調整したいなら、ArgparseのかわりにClickのようなパッケージをつかってみましょう。

Part7 解決への夢を打ち砕く実世界

7章は、技術的負債の管理の多くが、現実世界の絶えない変化を扱っているという事実のために準備することであると認めています。 例えば、モデルの出力を分類に変換するために閾値決定が必要なモデルや、あるいは真(True)または偽(False)のBool値を直接選ぶことができるモデルがあるかもしれません。

生物学的もしくは健康データを扱うグループや企業は、診断の基準が急速に変化することをよく知っています。 特にベイズ機械学習をしているときは、あなたの扱っている閾値が永遠に続くとは仮定してはいけません。

オンライン学習アルゴリズムによる決定境界……デプロイから12分後

オンライン学習アルゴリズムによる決定境界……デプロイから12分後

Best practice #18 モデルの現実世界でのパフォーマンスと、決定境界を常に監視しよう

このセクションではリアルタイムの監視の重要性を強調しています、私は間違いなくこれの良さがわかります。 どのようなことを監視するかについて、この論文は包括的なガイドではありませんが、いくつかの例を与えています。

ひとつは観測した観測したラベルの要約統計量と、予測ラベルの要約統計量を比較することです。 完璧ではありませんが、小さな動物の体重をチェックするようなものです。 何かがすごく間違っていれば、その問題をすぐに警告できます。

数えきれないほどたくさんのツールがあります。

近頃はだれもが、その母親さえもが、監視ツールのスタートアップを作っています。

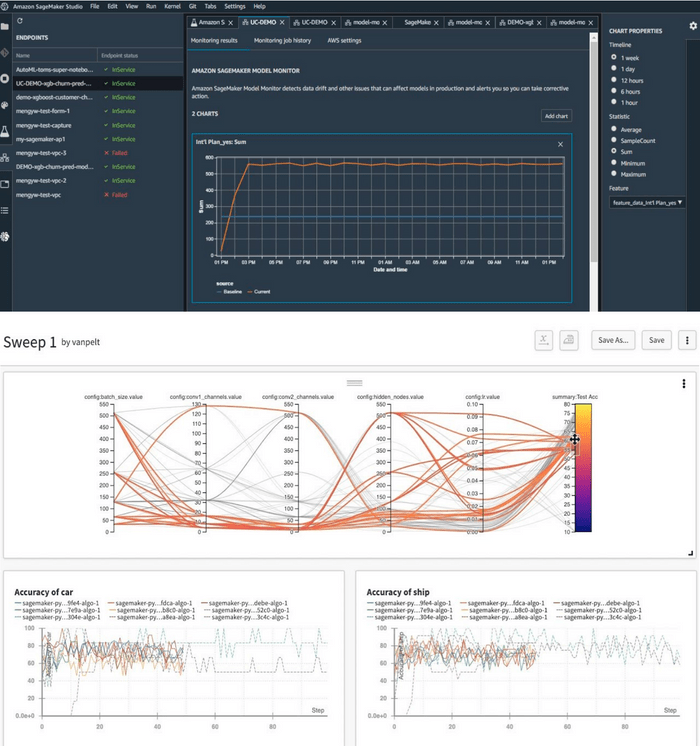

ここでは、他に比べてバグが少ないSageMakerとWeights & Biasesを例に挙げてみました。

数えきれないほどたくさんのツールがあります。

近頃はだれもが、その母親さえもが、監視ツールのスタートアップを作っています。

ここでは、他に比べてバグが少ないSageMakerとWeights & Biasesを例に挙げてみました。

(訳注: それぞれのリンクは、Amazon SageMaker Model Monitor と Weights & Biases)

Best practice #19 予測ラベルの分布が、観測ラベルの分布と似ているか確認しよう

あなたのシステムが現実世界のなにかを意思決定しているなら、レート制限(何某かの呼び出し回数制限)をしたいと思うでしょう。 たとえシステムが株の入札のための数百万ドルを任せられているものではなく、細胞培養インキュベーターのなにかが正しくないと警告を出すだけのシステムであっても、 単位時間あたりの行動制限を設定していないことでのちのち後悔することになります。

ML製品の初期の頭痛のタネのいくつかは、レート制限をしていないシステムで起こるでしょう。

ML製品の初期の頭痛のタネのいくつかは、レート制限をしていないシステムで起こるでしょう。

Best practice #20 機械学習システムによってもたらされる意思決定に制限を設けよう

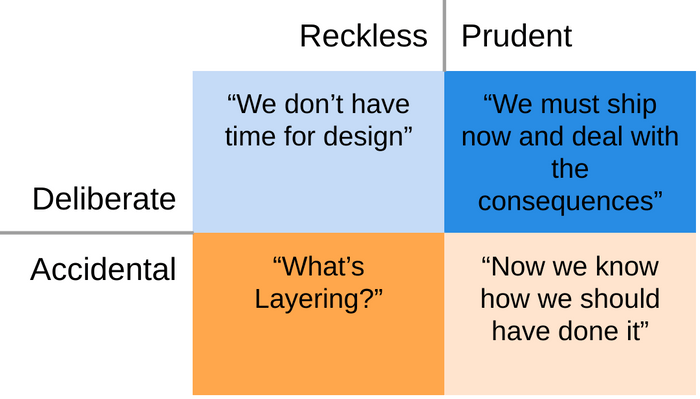

MLパイプラインが消費している、データの上位生産者(データを提供してくれている人・会社たち)によるどんな変化も、心に留めておきたいところです。 例えば、人間の血液やDNAサンプルの機械学習を走らせているどんな企業も、当然ながら、それらのサンプルがすべて標準化された手順で収集されていることを確認したいと考えています。 もしサンプルの多くが特定の集団からきたものであれば、企業は分析がゆがんでいないか確かめなければいけません。 もし培養された人間の細胞のシングルセルシーケンシングを扱っているのであれば、薬剤が作用したために死滅したがん細胞と、インターンが誤って培養した細胞を脱水させてしまったために死滅したがん細胞を混同していないことを確認する必要があります。

著者らは、理想的には、人間が対応可能でない時も、これらの変化に反応できるシステム (例えばログをつける、調節を自ら止める、決定閾値を変更する、技術者や修復可能な人に警告する) が必要だと言っています。

今は笑えるが、このようなミスは、思った以上に危険にさらされているのかもしれません。

今は笑えるが、このようなミスは、思った以上に危険にさらされているのかもしれません。

(訳注: DNA採取で用いる綿棒が汚染されていたことで、複数の事件で同一のDNAが検出され、架空の犯人ハイルブロンの怪人として騒がれた事件のこと。 上記画像の記事リンク。)

Best practice #21 入力データの背後にある仮説を確かめよう

Part8 奇妙なメタセクション

技術的負債論文の最後から2番目の章は他の領域について言及しています。 著者らは以前、技術的負債の種類として抽象化の失敗について言及してました、そしてどうも、論文の最初の7章の中に技術的負債の種類に収められなかったことにまで及んでいるようです。

サニティーチェック (Sanity Checks)

データのサニティーチェック(訳注: プログラムのソースコードの整合性・正当性を検査すること)をすることは非常に重要です。 新しいモデルを学習しているとき、モデルが少なくともデータのカテゴリーの一つの種類に過学習する可能性があることを確かめたいでしょう。 もし学習が収束しないなら、ハイパーパラメーターを調整する前に、データはランダムなノイズでないか確認した方がいいかもしれません。 著者らはこのように具体的ではなかったですが、言及するのに良いテストだと考えました。

Best practice #22 モデルが過学習する可能性があることを確認し、データの全てがノイズであったり、無信号でないことを確かめよう

再現性 (Reproducibility)

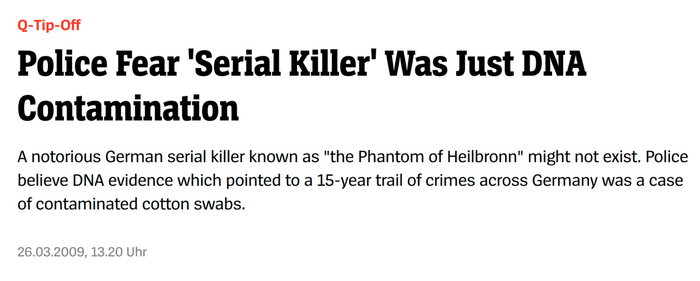

再現性。研究チームにいるあなた方の多くがこれに遭遇すると思います。 seedが設定されていないのコードや、故障中のノートブック、パッケージバージョンなしのレポジトリをみたことがあるでしょう。 技術的負債論文以降、何人かが、再現性チェックリストをつくっています。 ここに、4ヶ月前 hacker newsが特集したかなり良いリストがあります。

これはとても素晴らしいチェックリストの一つで、私も使っており、共に働くチームにも使うよう勧めています。

これはとても素晴らしいチェックリストの一つで、私も使っており、共に働くチームにも使うよう勧めています。

(訳注: このチェックリストのpdfのリンクはここ)

Best practice #23 研究のコードを公開するときは、再現性に関するチェックリストを使おう

アカデミアからのコードを再現したことのある、産業側の人間なら、私の言っている意味がわかると思います。

アカデミアからのコードを再現したことのある、産業側の人間なら、私の言っている意味がわかると思います。

プロセス管理 (Process management)

今まで議論してきた技術的負債の種類の多くは単一の機械学習モデルについて言及してきましたが、プロセス管理負債はおなじ時間にたくさんのモデルを実行した時に起こります、 1つの遅れたモデルが終わるのを待っている間に、すべてを止めようとは考えないでしょう。 システムレベルの臭いを無視しないのが重要で、また、モデルの実行時間をチェックすることが極めて重要です。 技術的負債論文が書かれて以降、機械学習エンジニアリングは少なくても大まかなシステム設計について考えて改良されてきています。

ボトルネックの同定に使われるチャートの一例

ボトルネックの同定に使われるチャートの一例

Best practice #24 機械学習モデルのために実行時間を確認・比較する習慣をつけよう

文化的負債 (Cultural debt)

文化的負債はとても厄介な種類の負債です。 著者らは、研究とエンジニアリングの間には時として格差があり、異種混合チームでは負債の返却行為は促しやすいと指摘しています。

個人的には、最後のこの部分は好きではありません。 私は、エンジニアディレクターとリサーチディレクターの両方に、最終的に報告する個人がいるチームをたくさん目撃しました。 エンジニアたちに、負債の修正に必要な変更のための権限のない異なる2つの部門にレポーティングさせることは技術的負債の解決策ではありません。 一部のエンジニアが、この技術的負債の矛先になるという意味では、これは解決策です。 そのようなエンジニアはNo Authority Gauntlet Syndrome (NAGS) (訳注: 権力なき挑戦症候群) になり、燃え尽き、最も同情的なマネージャーがバーニングマンに出ている間に、そのエンジニアが達成すべき作業を目標として持っていたマネージャーによって解雇されてしまうのです。 もし異種混合が助けになるなら、チームの 全体 に渡ることが必要です。

(訳注: バーニングマン は8~9月にアメリカで開催される大規模なイベントのこと)

それに加え、著者らは、チームや企業文化を語る時に、多くの人と同じ間違いをしていると思います。 特に、文化と価値観をごちゃまぜにしています。 企業やチームにとって向上心のある規則を列挙し、それを文化と呼ぶのは簡単です。 実行するのにMBAを持つ必要はないですが、それは実際の文化というより価値観です。 文化とは、二つの重みのある価値観のどちらかを選ぶよう要求した状況で、最終的に人々が実行することです。

これはUberが大きな問題に陥った原因です。 競争力と誠実さの両方が企業の価値観の一部でしたが、最終的には、文化は競争力がなによりも強調されることを要求しました、 例え人事部が絶対的に嫌なやつを会社に留めるために法律を破ることを意味しても。

(訳注: Uberの話はおそらく Reflecting on one very, very strange year at Uber で述べられている話)

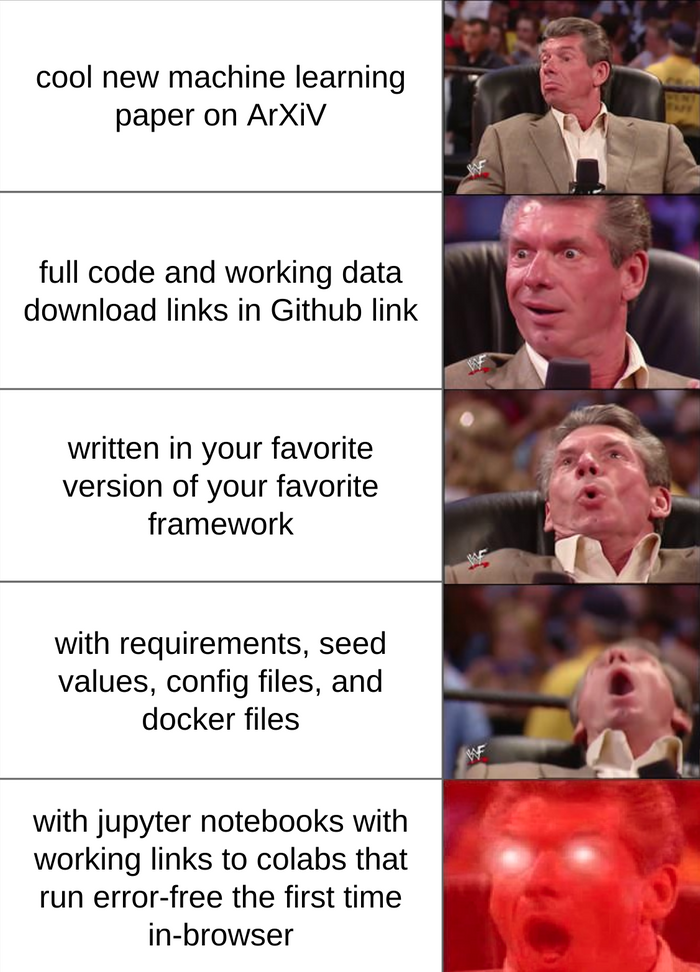

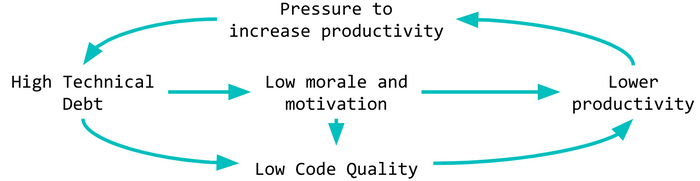

悪循環

悪循環

技術的負債についてのこのイシューは似たような状況でも起こります。 どれぐらい“メインテイナブル(保守可能な)”コードが必要かについて話すのは簡単です。 しかし、誰もが締め切りで追われ、ドキュメントの執筆がJIRAボードの優先度の中で下がっていくなら、最善の努力をしていても負債は積み重なっていきます。

技術的負債の様々な理由

技術的負債の様々な理由

(訳注: 「無鉄砲/慎重」と「意図的/不注意」の2つの基準を使った技術的負債の四象限)

Best practice #25 (それがどのような形であっても)技術的負債に対処するために、定期的に、交渉の余地のない時間を確保しておこう

Part9 技術的負債のリトマス試験

「負債」の一部は単なるメタファーだということを思い出してください。 どれだけ著者らがより厳格に見せようとしても、それにすぎません。

多くの負債と違って、機械学習の技術的負債は測るのが難しいものです。 与えられた時間であなたのチームがどれぐらいはやく動くかはどれぐらい負債をもっているかの指標にはなりません (新卒のプロダクトマネージャーが主張しているようにみえるにもかかわらず)。 指標にかかわらず、著者らは自身に問うための5つの質問を提案しています(ここではわかりやすく言い換えています)

- 最大のデータ資源を実行する、任意のNeurIPS論文からアルゴリズムを取得するのにどれぐらいかかるか?

- どのデータ依存性がコードの中で最も(もしくは全く)関わっているか?

- システムの一部を変更した場合、結果の変化をどれぐらい予測できるか?

- MLモデルの改良システムはゼロサムかpositive-sumか?

- ドキュメントはあるか?新人のための立ち上げプロセスではとっかかりになるものがあるか?

もちろん、2015年以降、他の記事や論文がより正確なスコアリングメカニズムを考えようとしています (scoring rubicsのように)。 ツールのいくつかは、不正確であっても、一眼でわかるスコアリングメカニズムを作成可能で、技術的負債を追跡する助けになります。

また、技術的負債のいくつかの解決策になると称賛されている解釈可能なMLツールは多くの進歩を遂げています。 それを心に留めたうえで、改めて “Interpretable Machine Learning” by Christoph Molnar (オンラインで利用可能) をおすすめします。

The 25 Best Practices in one place

これまでに言及したベストプラクティスを以下にまとめます。 これよりたくさんあるでしょうが、技術的負債の解消のツールはパレートの法則に従います: 技術的な負債の救済策の20%は、あなたの問題の80%を修正することができます。

- 解釈可能・説明可能なツールを使おう

- 可能であれば、説明可能な種類のモデルを使おう

- 常に、順番に下流モデルを再学習しよう

- アクセス鍵、ディレクトリの権限、サービス水準合意をセットアップしよう

- データのバージョン管理ツールを使おう

- 使っていないファイル、膨大な関係する特徴量を削除し、因果関係推論ツールを使おう

- データの依存関係を追跡する、無数にあるDevOpsツールのいくつかを使おう

- モデルの背後にある独立性の仮定を確認しよう (セキュリティーエンジニアの近くで働こう)

- 定期的なコードレビューを使おう (そして・またはコードチェックツールを使おう)

- 汎用的な目的の依存関係は特定のAPIにリパッケージしよう

- トップダウンの再設計・再実装によってパイプラインジャングルを取り除こう

- 定期的な点検を定めて、コードを取り除くための基準をつくろう、もしくはディレクトリかビジネスの物から遠い場所にコードをおこう

- 時間と共に強固になる抽象化を最新の状態にしておこう

TypingやDeimalのようなパッケージを使って、すべてのオブジェクトに対して 'float32' を使うのはやめよう- 進行中のものを同じディレクトリに置かない。片付けるか、きれいにしよう。

- エンドポイントが説明されていることを確認し、言語間で似たような抽象度を持つフレームワークを使用しよう

- ファイルパスやハイパーパラメーター、レイヤーの種類、レイヤーの順番や他の設定が一つの場所から設定できるか確かめよう

- モデルの現実世界でのパフォーマンスと、決定境界を常に監視しよう

- 予測ラベルの分布が、観測ラベルの分布と似ているか確認しよう

- 機械学習システムによってもたらされる意思決定に制限を設けよう

- 入力データの背後にある仮説を確かめよう

- モデルが過学習する可能性があることを確認し、データの全てがノイズであったり、無信号でないことを確かめよう

- 研究のコードを公開するときは、再現性に関するチェックリストを使おう

- 機械学習モデルのために実行時間を確認・比較する習慣をつけよう

- (それがどのような形であっても)技術的負債に対処するために、定期的に、交渉の余地のない時間を確保しておこう

おわりに・参考資料

今回翻訳する上で、ブログの元ネタとなる 技術的負債論文 と同じ著者で、技術的負債論文 が公開される1年前のNeurIPS2014で公開された論文 (Machine Learning:The High-Interest Credit Card of Technical Debt)について、日本語で解説している以下の情報を参考にさせていただきました。

- 「機械学習:技術的負債の高利子クレジットカード」のまとめ | Advanced Technology Lab

- 論文調査報告:Machine Learning:The High-Interest Credit Card of Technical Debt

- 機械学習:技術的負債の高金利クレジットカード – エンジニアの英語学習法

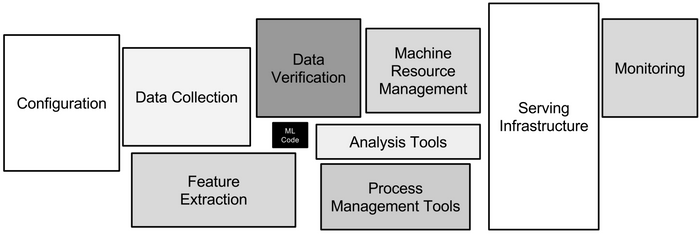

ちなみに、日本語の情報としては「High-Interest Credit Card~」のほうが豊富ですが、前編で紹介した、機械学習の技術的負債を象徴する図 (下記) は技術的負債論文が初出です。

改めて、翻訳の許可をしてくれた原著者のMatthew McAteer氏に感謝します。